Как стартапы могут использовать возможности нейросетей?

За последние несколько лет технологии машинного обучения вышли за рамки чисто исследовательского интереса и развились до промышленных масштабов. Вместе с этим также эволюционировали методы и инфраструктура, необходимая для поддержки крупномасштабного машинного обучения.

Это открывает для стартапов, многие из которых сейчас пытаются тем или иным образом применять машинное обучение в попытках завоевать свою долю рынка, как новые возможности, так и новые риски.

Революция в области глубокого обучения началась чуть более 9 лет назад когда в 2012 году проект под названием AlexNet подал заявку на ежегодный конкурс ImageNet LSVRC (соревнования среди проектов в области компьютерного зрения, организованные исследовательским сообществом).

Команда Alex Net (Алекс Крижевский, Илья Суцкевер и Джеффри Хинтон) создала систему для распознания фото-контента на основе сверточной нейронной сети. Они выиграли конкурс — опередив остальных участников со значительным отрывом — и сделали это с помощью системы, которая обучалась на видеокарте стоимостью 700 долларов.

Мир машинного обучения изменился навсегда.

В течение следующего года начали появляться стартапы, которые пытались повторить успех AlexNet. Моя предыдущая компания, AlchemyAPI (приобретена IBM в 2015 году), выпустила одну из первых коммерческих версий такой системы с нашим API для компьютерного зрения AlchemyVision еще в 2013 году.

В это время было основано множество других стартапов, включая DeepMind (приобретен Google), MetaMind (приобретен Salesforce) и Clarifai.

В мире науки тоже произошли кардинальные изменения — многие эксперты отбросили скептицизм в отношении искуственного интеллекта и стали сторонниками глубокого обучения.

Вернемся в 2022 год.

Нейросети изменили каждый аспект машинного интеллекта в программных системах, которые мы используем ежедневно — от распознания речи до наполнения нашей ленты новостей контентом (к лучшему или худшему).

Современные системы по-прежнему используют нейросети, но в совершенно ином масштабе.

Новейшие системы для понимания и генерации человеческого языка, такие как GPT-3 от OpenAI, обучались с использованием ресурсов суперкомпьютерного масштаба: тысячи графических процессоров (каждый стоимостью 10 000 долларов или более), вплетенных в сложную систему высокоскоростных сетевых соединений и инфраструктуры для хранения данных.

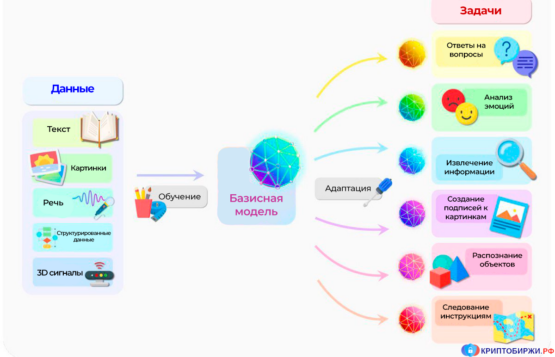

Покупайте, зарабатывайте криптовалюты вместе с редакцией сайта КРИПТОБИРЖИ.РФВ то время как системы 2012 года могли обучаться на видеокарте стоимостью 700 долларов, современные системы, часто называемые базисными моделями (англ. — “foundation models”) требуют вычислительных мощностей стоимостью в десятки миллионов.

Появление этих масштабных, дорогостоящих базисных моделей открывает новые возможности и риски для стартапов, которые хотят использовать инновации из области искусственного интеллекта и машинного обучения.

Хотя они, вероятно, не смогут конкурировать с Google, Facebook или OpenAI, небольшие организации могут использовать достижения этих гигантов, включая базисные модели, для разработки своих собственных приложений на базе технологий машинного обучения.

Предварительно обученные нейросети

Нейронные сети, такие как AlexNet, изначально обучались с нуля для каждой конкретной задачи. Это было возможно поскольку такой сети нужно всего несколько недель обучения на одном графическом устройстве.

Однако с ростом масштабов сетей, объемов обучающих данных и требований к вычислительным мощностям обучение модели становится все более сложной задачей.

Это привело к популяризации подхода, известного как предварительное обучение, при котором нейронная сеть сначала обучается на большом наборе общих данных, используя значительные объемы вычислительных ресурсов, а затем настраивается для решения поставленной задачи с использованием гораздо меньшего объема данных и вычислительных ресурсов.

В последние годы предобученные модели обрели большую популярность, поскольку индустриализация машинного обучения охватила многие области (например, обработка языка или речи), а объем данных, доступных для обучения моделей, резко возрос.

Использование предварительно обученных сетей может позволить стартапу, например, создать продукт с гораздо меньшими затратами в плане данных и вычислительных ресурсов, чем при запуске с нуля. Этот подход также становится популярным в академических кругах, где исследователи могут быстро настроить предварительно обученную сеть для новой задачи.

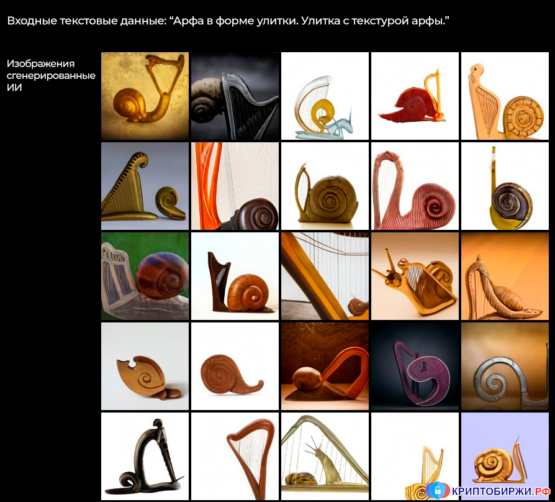

В определенных областях — включая понимание или генерацию текстовых данных, распознание фото- или видеоконтента и обработку звука — предварительное обучение продолжает развиваться с появлением таких базисных моделей, как BERT, GPT, DALL–E, CLIP и других.

Эти модели предварительно обучаются на больших наборах данных общего назначения (часто порядка нескольких миллиардов обучающих примеров) и выпускаются с открытым исходным кодом, такими компаниями как Google, Microsoft и OpenAI.

Сложно переоценить демократизующий эффект этих базисных моделей и скорость инноваций в области коммерческого применения машинного обучения.

Эти модели стали панацеей для тех представителей индустрии, у которых нет под рукой лишнего суперкомпьютера.

Они позволяют стартапам, исследователям и другим людям быстро познакомиться с новейшими подходами к машинному обучению без необходимости тратить время и ресурсы, нужные для обучения этих моделей с нуля.

Риски использования базисных моделей

Однако не все так радужно, как может показаться на первый взгляд — существует ряд рисков, связанных с использованием предварительно обученных базисных моделей.

Одним из таких рисков является постоянно растущий масштаб моделей.

Таким нейросетям, как Google T5-11b (выпущена в 2019 году), уже необходим целый кластер дорогостоящих графических процессоров просто для загрузки и прогнозирования. Для точной настройки этих систем требуется еще больше ресурсов.

Более поздние модели, созданные в 2021-2022 годах такими компаниями, как Google, Microsoft и OpenAI, часто настолько масштабны, что уже не выпускаются в виде открытого ПО – теперь их создание обходится в десятки миллионов долларов, и они все чаще рассматриваются как инвестиции в интеллектуальную собственность даже такими крупными корпорациями.

Однако, даже если бы эти модели попали в открытый доступ, простая загрузка этих сетей для составления прогнозов (“вывода”) требует огромного количества ресурсов, которыми не располагает большинство стартапов или исследователей.

Например, чтобы запустить GPT-3 от OpenAI необходимо весьма внушительное количество графических процессоров.

Даже при использовании современных облачных вычислений, например, Amazon Web Services, для этого потребовалось бы объединить десятки самых дорогих графических процессоров Amazon в высокопроизводительный вычислительный кластер.

Еще одной проблемной областью для тех, кто использует базовые модели, часто становится согласование данных.

Предварительное обучение на большом наборе данных общего назначения не гарантирует того, что сеть сможет выполнить новую задачу на проприетарных данных. Предобученная сеть может не иметь достаточного контекста или быть предвзята, и даже точная настройка может не сразу решить проблему.

Например, GPT-2, популярная модель для обработки естественного языка, была первоначально анонсирована в начале 2019 года и, таким образом, обучалась на основе доступных на тот момент данных.

Подумайте, сколько всего произошло с 2019 года – взять хотя бы пандемию COVID. Оригинальная модель GPT-2, несомненно, знает, что такое пандемия, но у нее нет подробных данных связанных именно с COVID-19 и его разновидностями.

Для наглядности, вот пример того, как GPT-2 пытается завершить предложение “COVID-19 – это …”:

GPT-2 (2019): “COVID-19 — это светодиодный излучатель большой емкости, который отображает информацию о размере и состоянии батареи”.

Для сравнения, GPT-J, языковая модель с открытым исходным кодом, выпущенная в 2021 году, завершает предложение следующим образом:

GPT-J (2021): “COVID-19 — это новый коронавирус, который в основном поражает дыхательную систему, вызывая заболевание с широким спектром клинических симптомов”.

Довольно существенная разница, не так ли?

Согласование наборов данных и актуальность обучающих данных могут иметь огромное значение в зависимости от области применения модели. Любой стартап, использующий базовые модели, должен уделять этому пристальное внимание.

Машинное обучение и облачные сервисы

Более простым решением является использование облачных API, но аутсорсинг — это не бесплатно.

Осознав проблемы, связанные с масштабом базисных моделей, такие компании, как OpenAI, Microsoft и Nvidia отреагировали созданием своих облачных API, которые позволяют использовать крупномасштабные модели, развернутые на базе их инфраструктуры.

И, конечно же, каждый крупный поставщик облачных сервисов теперь предлагает свой набор сервисов машинного обучения, а также, в некоторых случаях, процессоры, разработанные специально для этих задач.

Это может в некоторой степени облегчить жизнь стартапов, исследователей и даже отдельных любителей, у которых появилась возможность переложить затраты, связанные с вычислениями и инфраструктурой на более крупную компанию.

Однако такой подход сопряжен со своими рисками.

Если компания не располагает достаточными ресурсами для развертывания собственной модели, ей приходится полагаться на централизованных посредников.

Однако, эта возможность также сопряжена и с внешними рисками: перебои в работе сети, ограничения скорости обработки запросов, изменения в политике компании и тому подобные вещи могут стать серьезной проблемой для тех, кто использует облачные сервисы.

Кроме того, риск утечки интеллектуальной собственности, связанный с отправкой данных поставщикам облачных сервисов, может стать препятствием для тех, кто использует конфиденциальные наборы данных (некоторые из которых могут попадать под действие законодательства, например HIPAA).

Еще одним важным вопросом для тех, кто использует облачные API в своих проектах, является расчет себестоимости реализованной продукции (англ. — COGS).

Цены на услуги могут варьироваться от поставщика к поставщику, но само собой разумеется, что стоимость вызовов API, хранения данных, и облачных инстансов будет расти с ростом потребностей стартапа.

Многие компании, которые сегодня используют облачные API для машинного обучения, могут в конечном итоге попытаться перейти на самостоятельное обучение и развертывание моделей, чтобы получить больший контроль над своими бизнес-процессами и устранить внешние риски и затраты.

В силу тех возможностей и рисков, которые связаны с использованием предобученных моделей и облачных API, многие компании сейчас используют облачные API в “экспериментальной фазе”, чтобы обеспечить первоначальный импульс для разработки продукта.

На этом этапе они пытаются достичь соответствия продукта рынку. Использование облачных API может позволить компании быстро запустить свой продукт без необходимости инвестировать в дорогостоящую инфраструктуру, обучение модели или сбор данных.

Облачные сервисы машинного обучения и предварительно обученные модели от таких компаний, как Google, IBM, Microsoft и OpenAI, теперь обеспечивают работу тысячи стартапов и академических исследовательских проектов.

Убедившись, что их продукт соответствует рынку, компании часто переходят на автономные модели, чтобы сохранить контроль над данными, процессами и интеллектуальной собственностью.

Это может быть непросто, в силу того что компании необходимо развертывать свою собственную инфраструктуру, которая будет соответствовать требованиям модели, а также взять на себя издержки, связанные со сбором, аннотированием и хранением данных. С этой целью компании привлекают все большие объемы инвестиционного капитала.

К примеру, мой последний стартап, Hyperia, недавно как раз совершил такой переход.

На раннем этапе мы экспериментировали с использованием облачных API для распознания содержания деловых встреч и разговоров с клиентами. Но в конце концов мы бросились в самую гущу событий, начав крупномасштабный сбор данных и обучение модели для создания собственных речевых и языковых движков.

Для многих бизнес-моделей такая эволюция просто необходима, чтобы достичь положительной юнит-экономики и рыночной дифференциации.

Заключение

Базисные модели — одна из новейших прорывных тенденций в машинном обучении, но она не будет последней.

В то время как компании продолжают создавать все более масштабные суперкомпьютеры для машинного обучения (последние модели компании Facebook используют более 16 000 графических процессоров), исследователи заняты разработкой новых методов для снижения вычислительных затрат, связанных с обучением и развертыванием современных нейронных сетей.

Например последняя модель от Google под названием LaMDA способна обучаться более эффективно чем GPT-3, благодаря использованию ряда инновационных методов. Исследовательское сообщество также разрабатывает новые техники, такие как, например, дистилляция модели и другие, с целью уменьшить размер модели.

Эти и другие технологические достижения дают стартапам возможность продолжать создавать инновации — но важно смотреть в оба, поскольку этот ландшафт беспрестанно меняется.

Несколько ключевых выводов:

- Облачные API, безусловно, могут помочь компании быстрее выйти на рынок, но в долгосрочной перспективе их использование часто сопряжено со своими собственными рисками. Важно заранее продумать “план отступления”, чтобы судьба проекта не зависела целиком и полностью от этих API.

- Базисные модели могут значительно ускорить машинное обучение и снизить общие затраты на обучение и сбор данных, но важно помнить об ограничениях этих систем (например, связанных с релевантностью и актуальностью данных).

- Следите за тем, что выходит из крупных корпоративных лабораторий (Google, Microsoft, IBM, Baidu, Facebook, OpenAI и т.д.). Машинное обучение развивается чрезвычайно быстрыми темпами, каждый месяц появляются новые методы, модели и наборы данных. Это часто происходит совершенно неожиданно и может стать решающим преимуществом для вашей компании, если вы сможете быстро адаптироваться.

В конечном счете, сложно точно предсказать будущее машинного обучения и то, какое влияние оно окажет на стартапы и технологические компании. Но ясно одно: компании, которые осознают открывающиеся возможности и используют их рационально, имеют гораздо больше шансов на успех.

С оригинальным материалом вы можете ознакомиться здесь.

Присоединяйтесь к нашему DAO, где мы совместно вкладываем в новые криптовалюты:А как думаете вы — какое влияние окажет искусственный интеллект на мир будущего?

Давайте обсудим в комментариях ниже.

© Материал подготовлен для сайта рейтинга КРИПТОБИРЖ и может быть открыто распространен в сети при указании авторства.